"Nie możemy już zakładać, że cokolwiek jest prawdą". Rozmowa z laureatem Nagrody Pulitzera

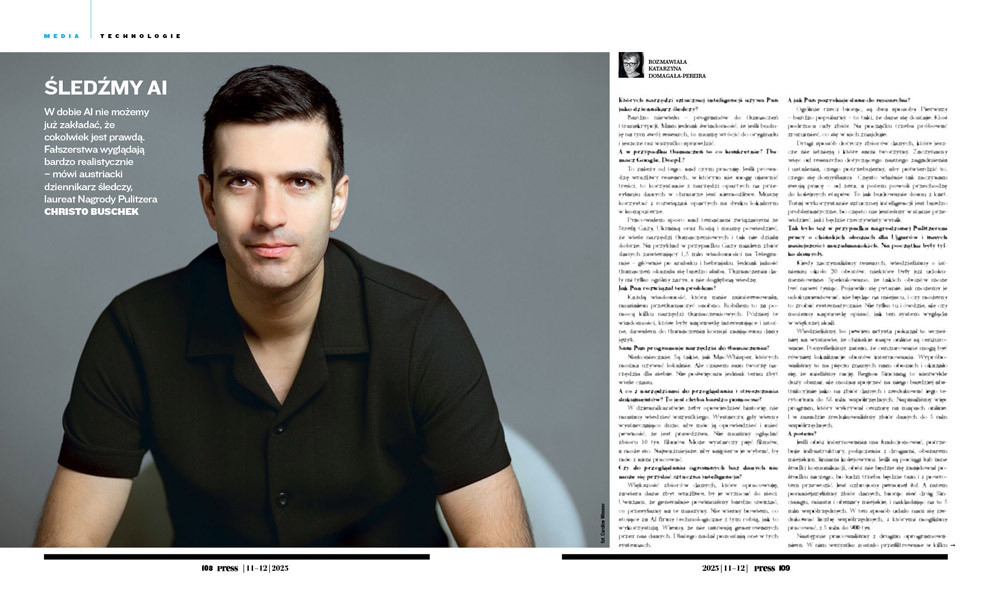

– Mieliśmy matrycę z 15 cechami. Im więcej cech miało dane miejsce, tym bardziej było prawdopodobne, że jest to obóz internowania – opowiada Christo Buschek (screen: YouTube/DW Global Media Forum)

W dobie AI nie możemy już zakładać, że cokolwiek jest prawdą. Fałszerstwa wyglądają bardzo realistycznie – mówi austriacki dziennikarz śledczy, laureat Nagrody Pulitzera Christo Buschek. Rozmawia z nim Katarzyna Domagała-Pereira.

Których narzędzi sztucznej inteligencji używa Pan jako dziennikarz śledczy?

Bardzo niewielu – programów do tłumaczeń i transkrypcji. Mam jednak świadomość, że jeśli buduję na tym swój research, to muszę wrócić do oryginału i jeszcze raz wszystko sprawdzić.

A w przypadku tłumaczeń to co konkretnie? Tłumacz Google, DeepL?

To zależy od tego, nad czym pracuję. Jeśli prowadzę wrażliwy research, w którym nie mogę ujawnić treści, to korzystanie z narzędzi opartych na przesyłaniu danych w chmurze jest niemożliwe. Muszę korzystać z rozwiązań opartych na dysku lokalnym w komputerze.

Pracowałem sporo nad tematami związanymi ze Strefą Gazy, Ukrainą oraz Rosją i muszę powiedzieć, że wiele narzędzi tłumaczeniowych i tak nie działa dobrze. Na przykład w przypadku Gazy miałem zbiór danych zawierający 1,5 mln wiadomości na Telegramie – głównie po arabsku i hebrajsku. Jednak jakość tłumaczeń okazała się bardzo słaba. Tłumaczenia dały mi tylko ogólny zarys, a nie dogłębną wiedzę.

Jak Pan rozwiązał ten problem?

Każdą wiadomość, która mnie zainteresowała, musiałem przetłumaczyć osobno. Robiłem to za pomocą kilku narzędzi tłumaczeniowych. Później te wiadomości, które były naprawdę interesujące i istotne, dawałem do tłumaczenia komuś znającemu dany język.

Sam Pan programuje narzędzia do tłumaczenia?

Niekoniecznie. Są takie, jak MacWhisper, których można używać lokalnie. Ale czasem sam tworzę narzędzia dla siebie. Nie poświęcam jednak temu zbyt wiele czasu.

A co z narzędziami do przeglądania i streszczania dokumentów? To jest chyba bardzo pomocne?

W dziennikarstwie, żeby opowiedzieć historię, nie musimy wiedzieć wszystkiego. Wystarczy, gdy wiemy wystarczająco dużo, aby móc ją opowiedzieć i mieć pewność, że jest prawdziwa. Nie musimy oglądać zbioru 10 tys. filmów. Może wystarczy pięć filmów, a może sto. Najważniejsze, aby najpierw je wybrać, by móc z nimi pracować.

Czy do przeglądania ogromnych baz danych nie może się przydać sztuczna inteligencja?

Większość zbiorów danych, które opracowuję, zawiera dane zbyt wrażliwe, by je wrzucać do sieci. Uważam, że generalnie powinniśmy bardzo uważać, co przesyłamy na te maszyny. Nie wiemy bowiem, co stojące za AI firmy technologiczne z tym robią, jak to wykorzystują. Wiemy, że nie usuwają generowanych przez nas danych. Dlatego nadal pozostają one w tych systemach.

A jak Pan pozyskuje dane do researchu?

Ogólnie rzecz biorąc, są dwa sposoby. Pierwszy – bardzo popularny – to taki, że dane się dostaje. Ktoś podrzuca cały zbiór. Na początku trzeba próbować zrozumieć, co się w nich znajduje.

Drugi sposób dotyczy zbiorów danych, które jeszcze nie istnieją i które sami tworzymy. Zaczynamy więc od researchu dotyczącego naszego zagadnienia i ustalenia, czego potrzebujemy, aby potwierdzić to, czego się domyślamy. Często właśnie tak zaczynam swoją pracę – od zera, a potem powoli przechodzę do kolejnych etapów. To jak budowanie domu z kart. Tutaj wykorzystanie sztucznej inteligencji jest bardzo problematyczne, bo często nie jesteśmy w stanie przewidzieć, jaki będzie rzeczywisty wynik.

Tak było też w przypadku nagrodzonej Pulitzerem pracy o chińskich obozach dla Ujgurów i innych mniejszości muzułmańskich. Na początku były tylko domysły.

Kiedy zaczynaliśmy research, wiedzieliśmy o istnieniu około 20 obozów, niektóre były już udokumentowane. Spekulowano, że takich obozów może być nawet tysiąc. Pojawiło się pytanie, jak możemy je udokumentować, nie będąc na miejscu, i czy możemy to zrobić systematycznie. Nie tylko tu i ówdzie, ale czy możemy naprawdę opisać, jak ten system wygląda w większej skali.

Wiedzieliśmy, bo pewien artysta pokazał to wcześniej na wystawie, że chińskie mapy online są cenzurowane. Pomyśleliśmy zatem, że cenzurowane mogą być również lokalizacje obozów internowania. Wypróbowaliśmy to na pięciu znanych nam obozach i okazało się, że mieliśmy rację. Region Sinciang to niezwykle duży obszar, ale można spojrzeć na niego bardziej abstrakcyjnie jako na zbiór danych i zredukować jego terytorium do 55 mln współrzędnych. Napisaliśmy więc program, który wykrywał cenzurę na mapach online. I w zasadzie zredukowaliśmy zbiór danych do 5 mln współrzędnych.

A potem?

Jeśli obóz internowania ma funkcjonować, potrzebuje infrastruktury, połączenia z drogami, obszarem miejskim, liniami kolejowymi. Jeśli są pociągi lub inne środki komunikacji, obóz nie będzie się znajdował pośrodku niczego, bo ludzi trzeba będzie tam i z powrotem przewozić. Jest uzbrojony personel itd. A zatem pomniejszyliśmy zbiór danych, biorąc sieć dróg Sinciangu, miasta i obszary miejskie, i nakładając na to 5 mln współrzędnych. W ten sposób udało nam się zredukować liczbę współrzędnych, z którymi mogliśmy pracować, z 5 mln do 900 tys.

Następnie pracowaliśmy z drugim oprogramowaniem. W nim wszystko zostało przefiltrowane w kilku etapach, aby wyeliminować obiekty, które nie posiadały określonych cech infrastrukturalnych i architektonicznych typowych dla takiego obozu. Widoczne są więc na przykład wieże strażnicze, bramy, baraki. Mieliśmy matrycę z 15 cechami. Jeśli widzieliśmy którąś z cech na zdjęciach satelitarnych, sprawdzaliśmy taką lokalizację. Im więcej cech miało dane miejsce, tym bardziej było prawdopodobne, że jest to obóz internowania.

W ten sposób udało się Wam zidentyfikować 268 obozów. Jak długo pracował Pan nad tym i w jak dużym zespole?

To były trzy osoby: Alison Killing – architektka z Rotterdamu, Megha Rajagopalan – dziennikarka, wówczas z BuzzFeed News, i ja jako programista. Całość zajęła nam około 18 miesięcy – dłużej, niż planowaliśmy, bo wybuchła pandemia. Mieliśmy jasno określone zadania. Najpierw musieliśmy zbudować całą technologię, oprogramowanie, aby faktycznie utworzyć zbiór danych, wykryć cenzurę i zbudować kolejny zbiór danych. Potem była weryfikacja i praca dziennikarska. Wszystko w procesie linearnym, co oznacza, że najpierw musiało się wydarzyć jedno, by potem zadziało się drugie. W dodatku w tym czasie nie była to nasza główna praca, więc musieliśmy robić jeszcze inne rzeczy.

Jest Pan freelancerem i jeśli taki research trwa półtora roku, to jak Pan to finansuje?

Wprawdzie rzeczywiście jestem freelancerem, ale teraz pracuję regularnie dla magazynu „Der Spiegel”. Wcześniej wszystko było oczywiście trochę trudniejsze i bardziej niepewne. Tworzy się projekt, a potem trzeba zabiegać o dofinansowanie. Nasz projekt o obozach był wspierany m.in. przez Open Technology Fund.

A czy w „Der Spiegel” zajmuje się Pan też dziennikarstwem danych?

Pewnym jego rodzajem. Nazywam to researchem opartym na danych. Różnice są może subtelne, ale staram się to rozróżniać. Dziennikarstwo danych stanowi jego istotną część, ale dziennikarstwo danych to tak naprawdę praca, którą wykonuje się na gotowym zbiorze danych.

Uzyskanym na przykład po wycieku? Czy to się często zdarza?

Tak. Jest też wielu dziennikarzy, którzy się w tym specjalizują. Obserwujemy wręcz eksplozję wycieków danych. Im bardziej społeczeństwo buduje świat na danych, tym więcej tych danych wycieka do dziennikarzy.

Myślę, że sztuczna inteligencja będzie również stanowiła problem dla tego rodzaju dziennikarstwa, ponieważ w dobie AI nie możemy już zakładać, że cokolwiek jest prawdą. Fałszerstwa wyglądają bardzo realistycznie i nasze wysiłki na rzecz potwierdzania autentyczności takich wycieków będą rosły. Im bardziej sztuczna inteligencja zakorzeni się w tym świecie, tym większe będą problemy z ustaleniem, czy coś w ogóle istnieje, czy nie.

I myślę, że będzie to problem dla tego typu dziennikarstwa, ponieważ bardzo często w przypadku wycieków nie wiadomo, jak dane zostały zebrane, jak je opracowano, skąd pochodzą ani jaki był proces, który za nimi stoi.

A czy zdarzyło już się Panu otrzymać zbiór danych, które okazały się nieprawdziwe?

Odpukać, nie. Ale jest jeszcze inny problem – błędna kontekstualizacja danych. Bo dane same w sobie nic nie mówią, są abstrakcyjne i mogą zawierać wiele prawd jednocześnie, a odpowiedź uzyska się dopiero po osadzeniu ich w kontekście i zadaniu pytań.

Czy dobrze wnioskuję, że sztuczna inteligencja jest zagrożeniem dla dziennikarstwa danych? Skoro trudno stwierdzić, czy są prawdziwe.

Problem, który widzę w związku z AI, polega na tym, że teraz otrzymujemy zbiory danych, a właściwie ich zalew, które nie mają już żadnego związku z realnym światem. Zostały po prostu wygenerowane w przestrzeni cyfrowej, w tym abstrakcyjnym świecie mediów społecznościowych, sztucznej inteligencji, i są oderwane od fizycznego świata. Nie wiemy już, skąd się coś bierze, czy jest wiarygodne. Dlatego myślę, że coraz więcej danych będzie wykorzystywanych jako broń. Zbiory danych będą tworzone po prostu dlatego, że mogą być stworzone. To już jest duży problem i my, dziennikarze, musimy się na to przygotować, bo ograniczy to poważnie dziennikarstwo bazujące na wycieku danych.

Abstrahując od dziennikarstwa danych, już chyba każda redakcja ma narzędzia AI, które są integralną częścią pracy dziennikarskiej. Jak Pan to ocenia?

Pamiętajmy, co powiedział Marshall McLuhan: „Najpierw kształtujemy nasze narzędzia, a następnie nasze narzędzia kształtują nas”. Jeśli zaczniemy korzystać z narzędzi AI, powinniśmy przyjrzeć się temu, co nam dają i ile nas kosztują. Ale musimy też zrozumieć, jaką ogólną cenę za nie płacimy. Zwłaszcza w przypadku narzędzi technologicznych, które bierzemy za szybkie, krótkoterminowe i tanie rozwiązania, a w rzeczywistości wiąże się to również z większymi kosztami. Mamy za darmo albo płacimy abonament za Open AI czy Perplexity, ale sztuczna inteligencja kosztuje znacznie więcej. Na przykład w przypadku Anthropic użytkownik płaci za abonament 100 dolarów miesięcznie, ale wiemy, że powoduje w niektórych przypadkach koszty rzędu 10-12 tys. dolarów.

Jeśli zaczniemy budować nasze działy redakcyjne, procesy, metody pracy wokół narzędzi AI, co stanie się za trzy, pięć lat? Czy będziemy mogli pracować bez tych narzędzi i co się stanie, gdy koszty będą stopniowo rosły, ponieważ firmy technologiczne będą chciały w pewnym momencie odzyskać swoje pieniądze? Czy będziemy mogli kontynuować pracę tak jak wcześniej? Czy już tylko obsługiwać te narzędzia?

Ale czy nie dotyczy to każdego nowego narzędzia, którym zaczynamy się posługiwać?

Każde narzędzie wymaga dostosowania naszych metod pracy. Bardzo niewiele narzędzi pozwala nam najpierw zdefiniować metody pracy, a następnie dostosować narzędzia do naszych potrzeb. To idealne rozwiązanie, ale większość narzędzi, takich jak chatbot oparty na sztucznej inteligencji, wymaga od nas zmiany naszej pracy, aby móc w pełni wykorzystać możliwości narzędzi. To ogromne zagrożenie, choć jest bardzo subtelne, nawet o nim nie myślimy. W pewnym momencie będziemy tworzyć projekty tak, aby móc korzystać z tego narzędzia. Zaczniemy budować projekty wokół niego.

(fot. Caroline Wimmer)

CHRISTO BUSCHEK – austriacki programista i dziennikarz śledczy, obecnie pracuje m.in. dla niemieckiego magazynu „Der Spiegel”. Specjalizuje się w tworzeniu oprogramowania i metod researchu opartego na danych. Jego programy zostały wykorzystane m.in. do stworzenia największego archiwum zbrodni wojennych popełnionych w Syrii. Za projekt „Built to Last” o chińskich obozach internowania Buschek otrzymał w 2021 roku Nagrodę Pulitzera w kategorii reportażu międzynarodowego.

„Die Welt” zaprezentował ostatnio pierwszy w Niemczech program telewizyjny zrobiony w pełni przez AI. Prezenterem był awatar. Są też gazety, w których część artykułów pisze sztuczna inteligencja. Czy to w ogóle ma jakąś dziennikarską wartość?

W przypadku awatarów i reporterów AI nie chodzi tak naprawdę o dziennikarstwo, ale raczej o tworzenie treści na platformach technologicznych. A dziennikarstwo to coś więcej niż content. Dlatego nie postrzegam tego jako pracy dziennikarskiej. Wchodzenie w te obszary to decyzja podjęta przez poszczególne media i to jest absolutnie uzasadnione, ale to nie jest dziennikarstwo.

Sztuczna inteligencja i wszystko, co się z nią wiąże, kryje w sobie coś więcej, czemu nie przyglądamy się wystarczająco uważnie. Kiedy mówimy o AI, ludziach i firmach, które za nią stoją, tak naprawdę mówimy o tych samych nazwiskach i firmach, o których mówiliśmy 10–15 lat temu: OpenAI, Microsoft, Meta, Mark Zuckerberg, Jeff Bezos… W przeszłości chodziło o media społecznościowe, potem była wirtualna rzeczywistość. Teraz to sztuczna inteligencja. Jeśli tradycyjne media zaczną naśladować platformy technologiczne i na nich polegać, to ostatecznie, za pięć czy dziesięć lat, skończy się to dla nich bardzo źle.

To jakie jest rozwiązanie?

Dla mnie osobiście zasady i wartości są ważne i uważam, że szczególnie w dziennikarstwie śledczym musimy się ich trzymać. To rzetelność, fakty, niewprowadzanie ludzi w błąd, uporządkowanie, kontekst, przedstawianie historii – to wszystko są podstawowe kompetencje dziennikarzy. Musimy o tym pamiętać.

A jakie standardy etyczne powinny obowiązywać w dziennikarstwie wykorzystującym AI?

Jestem pewien, że każdy odpowie na to pytanie nieco inaczej. Ja odróżniam używanie czegoś jako narzędzia od używania czegoś do produkcji. Życzyłbym sobie, żeby w tym drugim przypadku było to wyraźnie zaznaczone. Jesteśmy to winni czytelnikom, no i ponosimy odpowiedzialność w świetle prawa prasowego.

Kiedy piszemy tekst, uznałbym to za straszne, gdyby sztuczna inteligencja zrobiła to za nas, ponieważ tracimy kontrolę, a uważam, że kontrola jest ważna. Ale wiem też, że istnieją ograniczenia produkcyjne, presja czasu i wiele innych okoliczności, które trzeba brać pod uwagę.

Często powtarza Pan, że sztuczną inteligencję należy dziennikarsko śledzić, spojrzeć za kulisy. Czemu konkretnie się przyglądać? Algorytmom?

Jest kilka firm, które są niezwykle potężne i wpływowe. I kiedy przyglądamy się tym firmom, możemy do nich podejść na różnych poziomach. Klasycznie „follow the money” – poprzez pieniądze, dokumenty, transakcje biznesowe itd. – aby zrozumieć, jak ci aktorzy działają na świecie. Można też śledczo przyglądać się samym artefaktom technologicznym, czyli produktom platform i firm technologicznych. Jeśli spojrzymy na przykład na sztuczną inteligencję, to istnieją zasadniczo trzy rodzaje artefaktów, które te firmy wytwarzają: modele algorytmiczne, zbiory danych i benchmarki wokół nich.

Modele są niezwykle trudne i niewytłumaczalne, są również zamknięte. Nie wiemy, jak konkretnie działają. Zamiast tego znamy na przykład zbiory danych używane do trenowania tych modeli i możemy do nich podejść w sposób śledczy. Myślę, że my, dziennikarze, musimy coraz częściej postrzegać artefakty technologiczne jako obiekty badań śledczych. To bardzo niszowe zagadnienie, ale myślę, że nastąpi większa zmiana w kierunku postrzegania algorytmów, danych i procesów technologicznych jako obiektów dziennikarskich śledztw, ponieważ mają ogromne znaczenie dla przyszłości.

Autorka jest dziennikarką Deutsche Welle w Bonn

***

Ta rozmowa Katarzyny Domagały-Pereiry z Christo Buschekiem pochodzi z magazynu „Press” – wydanie nr 11-12/2025. Teraz udostępniliśmy ją do przeczytania w całości dla najaktywniejszych Czytelników.

„Press” do nabycia w dobrych salonach prasowych lub online (wydanie drukowane lub e-wydanie) na e-sklep.press.pl.

Czytaj też: Nowy „Press”: Michał Przedlacki, afera z książką Opolskiej i kto zarabia na AI

Katarzyna Domagała-Pereira